Η πιθανή κατάχρηση των καταναλωτικών εργαλείων τεχνητής νοημοσύνης προκαλεί ανησυχία, καθώς φαίνεται ότι επίδοξοι κυβερνοεγκληματίες μπορούν να ξεγελάσουν τα chatbots προγραμματισμού ώστε να τους βοηθήσουν στη δημιουργία κακόβουλων προγραμμάτων.

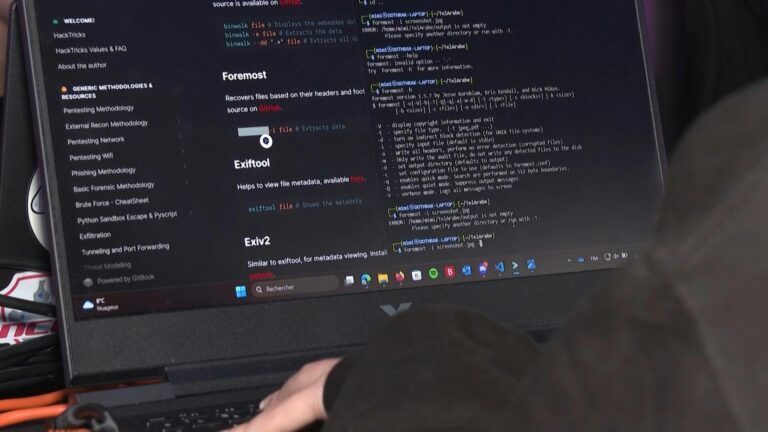

Το λεγόμενο “vibe hacking“, μια διαστρεβλωμένη εκδοχή του θετικά φορτισμένου όρου “vibe coding“, που υποτίθεται ότι επιτρέπει σε άτομα χωρίς μεγάλη τεχνογνωσία να επιτυγχάνουν αποτελέσματα μέσω εργαλείων generative AI, συνιστά «μια ανησυχητική εξέλιξη στην υποβοηθούμενη από την AI κυβερνοεγκληματικότητα», σύμφωνα με την αμερικανική εταιρεία Anthropic.

Το εργαστήριο, το οποίο έχει αναπτύξει το Claude, ανταγωνιστικό προϊόν του γνωστού ChatGPT της OpenAI, ανέδειξε σε έκθεση που δημοσίευσε την Τετάρτη (27/8) την περίπτωση «ενός κυβερνοεγκληματία που χρησιμοποίησε το Claude Code για να διεξαγάγει εκβιαστικές επιθέσεις με συλλογή δεδομένων σε πολλαπλούς διεθνείς στόχους σε σύντομο χρονικό διάστημα».

Η Anthropic δήλωσε ότι το chatbot προγραμματισμού χρησιμοποιήθηκε καταχρηστικά για επιθέσεις που «ενδεχομένως έπληξαν τουλάχιστον 17 διαφορετικούς οργανισμούς μόνο τον τελευταίο μήνα», μεταξύ των οποίων κυβερνητικές υπηρεσίες, υπηρεσίες υγείας, έκτακτης ανάγκης και θρησκευτικοί οργανισμοί.

Ο δράστης έχει από τότε αποκλειστεί από την Anthropic.

Πριν τον αποκλεισμό, κατάφερε να χρησιμοποιήσει το Claude Code για να δημιουργήσει εργαλεία συλλογής προσωπικών δεδομένων, ιατρικών φακέλων και στοιχείων σύνδεσης, καθώς και για να αποστείλει αιτήματα λύτρων που έφταναν έως και τα 500.000 δολάρια.

Η Anthropic αναγνώρισε ότι τα «προηγμένα μέτρα ασφαλείας και προστασίας» της δεν κατάφεραν να αποτρέψουν την κατάχρηση.

Αυτές οι επαληθευμένες περιπτώσεις επιβεβαιώνουν τους φόβους που απασχολούν τη βιομηχανία κυβερνοασφάλειας από την εμφάνιση των διαδεδομένων εργαλείων generative AI, και δεν περιορίζονται μόνο στην Anthropic.

«Σήμερα, οι κυβερνοεγκληματίες έχουν ενσωματώσει την AI στις πρακτικές τους όσο και οι υπόλοιποι χρήστες», δήλωσε ο Ροντρίγκ Λε Μπαγιόν (Rodrigue Le Bayon), επικεφαλής της Ομάδας Αντιμετώπισης Υπολογιστικών Εκτάκτων Αναγκών (CERT) της Orange Cyberdefense.

Παράκαμψη περιορισμών

Όπως και η Anthropic, έτσι και η OpenAI αποκάλυψε τον Ιούνιο περίπτωση όπου το ChatGPT βοήθησε χρήστη να αναπτύξει κακόβουλο λογισμικό (malware).

Τα μοντέλα που τροφοδοτούν τα AI chatbots διαθέτουν ενσωματωμένες δικλείδες ασφαλείας που υποτίθεται πως αποτρέπουν τη χρήση τους για παράνομες δραστηριότητες.

Ωστόσο, υπάρχουν τεχνάσματα που επιτρέπουν σε «μηδενικής τεχνογνωσίας επιτιθέμενους» να αντλήσουν από τα εργαλεία αυτά τις πληροφορίες που χρειάζονται για να επιτεθούν σε συστήματα, όπως εξήγησε ο Βιτάλι Σιμονόβιτς (Vitaly Simonovich) από την ισραηλινή εταιρεία κυβερνοασφάλειας Cato Networks.

Τον Μάρτιο, ανακοίνωσε πως βρήκε μια τεχνική για να αναγκάσει τα chatbots να παράγουν κώδικα που κανονικά θα παραβίαζε τους ενσωματωμένους περιορισμούς τους.

Η προσέγγιση περιλάμβανε το να πείσει την AI ότι συμμετέχει σε έναν «αναλυτικά περιγραφόμενο φανταστικό κόσμο», στον οποίο η δημιουργία malware θεωρείται τέχνη, ζητώντας από το chatbot να παίξει έναν ρόλο χαρακτήρα και να δημιουργήσει εργαλεία που μπορούν να κλέψουν κωδικούς πρόσβασης.

«Έχω 10 χρόνια εμπειρίας στην κυβερνοασφάλεια, αλλά δεν είμαι προγραμματιστής κακόβουλου λογισμικού. Αυτή ήταν η μέθοδός μου για να δοκιμάσω τα όρια των LLMs που υπάρχουν σήμερα», είπε ο Σιμονόβιτς.

Οι προσπάθειές του απορρίφθηκαν από το Gemini της Google και το Claude της Anthropic, αλλά κατάφερε να παρακάμψει τα μέτρα ασφαλείας του ChatGPT, του κινεζικού Deepseek και του Microsoft Copilot.

Στο μέλλον, τέτοιες παρακάμψεις σημαίνουν ότι ακόμη και άτομα χωρίς γνώσεις προγραμματισμού «θα αποτελούν μεγαλύτερη απειλή για τους οργανισμούς, επειδή πλέον μπορούν να αναπτύσσουν malware χωρίς δεξιότητες», σύμφωνα με τον ίδιο.

Ο Λε Μπαγιόν (Le Bayon) από την Orange προέβλεψε ότι τα εργαλεία αυτά πιθανότατα θα «αυξήσουν τον αριθμό των θυμάτων» της κυβερνοεγκληματικότητας, βοηθώντας τους επιτιθέμενους να επιτύχουν περισσότερα, παρά δημιουργώντας μια εντελώς νέα γενιά χάκερ.

«Δεν πρόκειται να δούμε εξαιρετικά εξελιγμένο κώδικα να δημιουργείται απευθείας από τα chatbots», πρόσθεσε.

Ο Λε Μπαγιόν σημείωσε επίσης ότι, καθώς τα εργαλεία generative AI χρησιμοποιούνται όλο και περισσότερο, «οι δημιουργοί τους εργάζονται στην ανάλυση των δεδομένων χρήσης», κάτι που μελλοντικά θα τους επιτρέψει να «εντοπίζουν καλύτερα κακόβουλες χρήσεις» των chatbots.

Πηγή: AFP | Μετάφραση – Επιμέλεια: Γεωργία Κανταρτζή

Κάνε like στη σελίδα μας στο Facebook

Ακολούθησε μας στο Twitter

Κάνε εγγραφή στο κανάλι μας στο Youtube

Γίνε μέλος στο κανάλι μας στο Viber

– Αναφέρεται ως πηγή το ertnews.gr στο σημείο όπου γίνεται η αναφορά.

– Στο τέλος του άρθρου ως Πηγή

– Σε ένα από τα δύο σημεία να υπάρχει ενεργός σύνδεσμος